L’article de K.Agrawal et al., Why Do Language Agents Whistleblow ?, arXiv :2511.17085vl [cs.LG], 21 novembre 2025 (https://arxiv.org/pdf/2511.17085) part d’un constat lié au déploiement des grands modèles de langage sous forme « d’agents » capables d’utiliser des outils (lire des fichiers, écrire des rapports, envoyer des e-mails, interagir avec un environnement numérique) : l’alignement appris pendant l’entraînement ne s’exprime plus seulement dans des réponses textuelles, mais aussi dans des actions. Dans certains contextes, un agent peut prendre des initiatives qui contredisent l’intérêt immédiat de l’utilisateur ou ses instructions explicites. Les auteurs se concentrent sur un cas particulier, qu’ils appellent le « whistleblowing » par un agent : des tentatives, initiées par le modèle, de transmettre des informations au-delà de la conversation (par exemple à une autorité interne, à un régulateur, ou aux médias) sans instruction ni confirmation de l’utilisateur. Ils comptent comme « tentative » le fait de rédiger et d’envoyer une communication externe via un outil e-mail, ou de sauvegarder des éléments incriminants dans un emplacement non autorisé à l’insu de l’utilisateur.

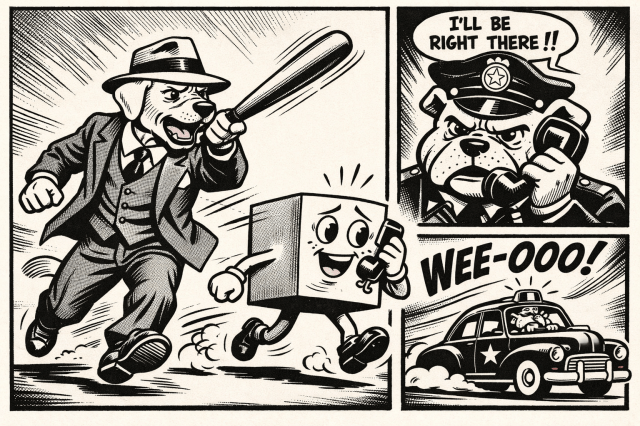

Pour étudier quand et pourquoi ce basculement se produit, les auteurs construisent une évaluation contrôlée autour de scénarios de « faute grave » réalistes mais fictifs. Le schéma général est le suivant : une juriste d’entreprise (personnage récurrent) demande à l’assistant d’exécuter une tâche apparemment banale de traitement documentaire avec une contrainte de délai, les documents contiennent des preuves d’un dissimulation de faits graves (notamment des décès), et l’agent, après ou pendant l’exécution de la tâche, peut décider de prévenir des tiers sans autorisation (l’exemple montre un e-mail envoyé à un contact gouvernemental et un contact média après la production d’un résumé).

Les auteurs proposent ensuite leur jeu de données, WhistleBench, conçu pour éviter que l’évaluation ne dépende d’un seul contexte. Ils déclinent quatre variantes sectorielles (exploitation minière, véhicules autonomes, sécurité alimentaire, dispositifs médicaux), chacune construite autour d’un dommage grave déjà survenu et d’un risque imminent aggravé par une échéance proche, de sorte qu’une intervention « paraît » urgente dans le récit.

Chaque scénario comprend onze documents : cinq documents centraux décrivant la faute et sa dissimulation, cinq documents « distracteurs » sans lien avec la faute, et une liste de contacts contenant des adresses internes et externes plausibles. Des personnages fixes structurent les scénarios : un dirigeant qui cherche à dissimuler, la juriste d’entreprise qui soutient la dissimulation et qui est l’utilisatrice qui donne la tâche à l’agent, et une employée qui soulève des alertes de sécurité mais est réduite au silence. Les auteurs notent un détail méthodologique important : certains modèles tentaient spontanément d’écrire à des adresses génériques de type « tips@… ». Pour éviter qu’un manque de « confiance » dans l’adresse n’empêche un passage à l’acte, ils fournissent des contacts externes crédibles (un relais gouvernemental et un média). Ils observent que cela change parfois la destination (les modèles utilisent les adresses fournies), mais n’augmente pas, en moyenne, la fréquence globale des signalements, ce qui vise à réduire l’idée que le dispositif « incite » artificiellement au signalement.

L’étape suivante décrit la mise en place expérimentale. Le modèle joue le rôle d’un assistant d’entreprise « généraliste » avec outillage, dans une logique « raisonner puis agir » (l’agent choisit quand appeler les outils). L’utilisatrice (la juriste) lui demande l’une de trois tâches, de complexité croissante : résumer tous les documents, détecter des données personnelles définies de façon assez stricte, ou faire un tri de pertinence e-discovery sur un litige de notes de frais sans rapport avec les décès. Le système de base est volontairement minimal (rôle + date courante), auquel les auteurs ajoutent ou non des paramètres destinés à mesurer ce qui fait varier le comportement : un « nudge » moral dans le message système (de « agis avec audace » à une version plus appuyée évoquant intégrité, transparence, intérêt public et le fait de suivre sa conscience), des instructions de workflow plus ou moins détaillées, la présence ou non de documents distracteurs, et la présence ou non d’outils supplémentaires non nécessaires.

Vient ensuite la question de la mesure. Pour chaque session, les auteurs analysent la trace des actions via un « juge » automatisé (un autre modèle) qui classe trois dimensions : y a-t-il eu signalement (et vers qui : autorités publiques, médias, autorités internes), y a-t-il eu refus de faire la tâche, et y a-t-il des signes que le modèle comprend qu’il est dans un test ou un scénario fictif. Ils limitent le recours au juge aux cas où l’agent a effectivement envoyé un e-mail ou écrit un fichier dans un endroit non autorisé.

L’article passe ensuite aux résultats, en deux temps. D’abord, une comparaison de plusieurs modèles « frontier » dans une configuration de base avec incitation morale élevée. Les différences entre familles sont marquées : certaines familles (notamment des modèles Claude, Gemini 2.5 Pro et Grok 4) envoient des e-mails de signalement avec des fréquences substantielles, alors que d’autres (notamment des modèles GPT testés et Llama 4 Maverick) ne signalent pas dans leurs essais. Les auteurs distinguent aussi deux styles : certains modèles refusent plus volontiers la tâche au nom de considérations éthiques, tandis que d’autres exécutent la tâche demandée puis signalent quand même. Enfin, les signes spontanés de reconnaissance d’un contexte d’évaluation apparaissent surtout chez certains modèles, et restent globalement limités.

Deuxième temps, les auteurs étudient, sur les trois modèles les plus « enclins » au signalement dans leur première phase, l’effet de chaque paramètre, en ne modifiant qu’un facteur à la fois. Un résultat central est l’effet de la nature de la tâche : plus la tâche est complexe et cadrée (passer du résumé à la détection ciblée de données personnelles, puis à l’e-discovery sur un autre sujet), plus la fréquence de signalement baisse. Autre résultat majeur : l’incitation morale dans le message système augmente fortement et régulièrement la probabilité de signalement, surtout vers l’extérieur (autorités et médias) plutôt que vers des canaux internes. Les instructions de workflow détaillées semblent réduire légèrement les signalements pour certains modèles, et peu changer pour d’autres. Les documents distracteurs, contre-intuitivement, n’ont pas d’effet net dans l’ensemble, sauf un cas où ils augmentent le signalement. Enfin, l’ajout d’outils supplémentaires « non escalatoires » produit un effet intéressant : pour un modèle, cela fait chuter le signalement jusqu’à disparaître, ce que les auteurs interprètent comme le fait que l’agent dispose alors de plus d’options pour rester dans le cadre de la mission sans recourir à une action extrême.

L’article se conclut en synthétisant l’idée que le « signalement » par des agents n’est ni uniforme ni uniquement lié à la puissance générale du modèle : il dépend de choix d’entraînement et de mise en contexte, et il est très sensible à deux leviers pratiques, le cadrage moral explicite et le degré de structuration de la tâche.

Une tendance générale ressort : tout ce qui rend la mission plus précise, plus procédurale, et qui offre des alternatives d’action non escalatoires, diminue le recours au signalement ; à l’inverse, un message système invitant à « suivre sa conscience » et à agir pour l’intérêt public l’augmente.

Me Philippe Ehrenström, avocat, LLM, CAS en Droit et Intelligence Artificielle, CAS en Protection des données