L’article de H. van Kolschooten et al, Legal, ethical, and policy challenges of artificial intelligence translation tools in healthcare, in : van Kolfschooten et al. Discover Public Health, (2025) (https://doi.org/10.1186/s12982-025-01277-z) examine l’usage croissant, en Europe, d’outils de traduction fondés sur l’intelligence artificielle (IA) comme Google Translate et ChatGPT pour surmonter les barrières linguistiques entre soignants et patients.

Le point de départ est pratique : l’interprétariat professionnel est souvent difficile d’accès (coût, manque de disponibilité, droits variables selon les pays), alors que ces outils sont rapides, gratuits et omniprésents.

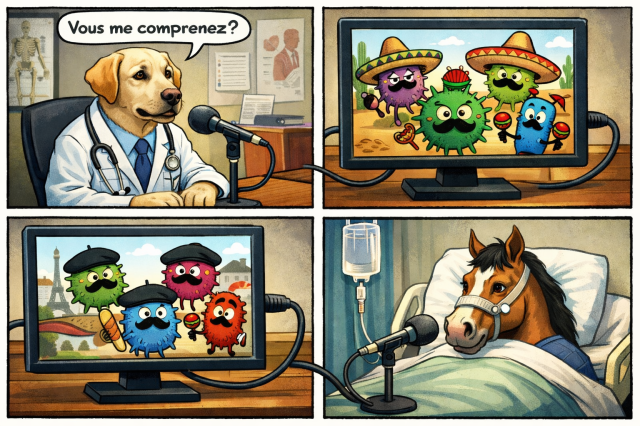

Les auteurs distinguent deux usages principaux : la traduction de textes (par exemple consignes de sortie, instructions de prise de médicaments, formulaires) et la traduction de la parole en temps réel (notamment via la fonction vocale de Google Translate).

Leur question est juridique et éthique : quels risques ces traductions automatisées font-elles peser sur les droits des patients, et dans quelle mesure le droit européen protège-t-il contre ces risques ?

Sur le plan technique, Google Translate repose surtout sur des modèles conçus pour la traduction, entraînés sur des paires de phrases alignées entre langues, et peut transformer la voix en texte puis en voix (reconnaissance vocale et synthèse). ChatGPT repose sur un modèle généraliste de langage, entraîné sur de très grands corpus non alignés, capable de produire une traduction écrite par prédiction de suites de mots plausibles. Dans les deux cas, il s’agit d’outils généralistes, non conçus ni validés pour un usage médical, ce qui compte juridiquement : leurs politiques d’utilisation déconseillent ou n’encadrent pas l’usage clinique, et surtout ils ne sont pas intégrés à des dispositifs de contrôle qualité et d’obligation de résultat comparables à ceux des dispositifs médicaux ou des services d’interprétariat.

Les auteurs combinent deux méthodes. D’une part, ils analysent les conditions et politiques publiques de Google Translate et de ChatGPT (conservation des données, transparence, responsabilité, garde-fous “santé”). D’autre part, ils analysent, de manière doctrinale, trois cadres juridiques européens susceptibles de s’appliquer : le Règlement général sur la protection des données (RGPD), le Règlement sur les dispositifs médicaux (MDR) et l’AI Act (règlement européen sur l’IA). Ils en tirent un constat central : la protection existe, mais elle est partielle et laisse des “zones grises” importantes lorsque des outils généralistes sont utilisés dans un contexte à haut risque comme les soins.

Le premier ensemble de risques concerne la vie privée et la confidentialité. Traduire une plainte, un diagnostic, une liste de médicaments ou une lettre médicale implique souvent de traiter des données particulièrement sensibles. Or, l’utilisation d’un service en ligne signifie typiquement que les informations sont transmises à un prestataire externe, parfois stockées, analysées ou réutilisées pour améliorer le service. Les politiques examinées indiquent que des données peuvent être conservées et réemployées (avec des possibilités d’opt-out limitées selon les versions et réglages), sans dispositif spécifique “santé” ni garanties compréhensibles pour un patient. Cela crée plusieurs points de friction pour un juriste : qui est responsable du traitement (l’hôpital, le médecin, le fournisseur de l’outil, ou plusieurs acteurs)? sur quelle base légale repose ce traitement et, surtout, l’éventuelle réutilisation ? quels flux transfrontières de données existent ? et comment informer le patient de façon suffisamment claire ? Les auteurs rappellent que des incidents réels (fuites, cyberattaques) illustrent que le risque n’est pas théorique : la donnée de santé est une cible, et la traduction peut devenir un canal involontaire d’exposition.

Le deuxième ensemble de risques touche l’autonomie du patient, le droit à l’information et le consentement éclairé. En médecine, comprendre est une condition du choix : si une traduction est inexacte, trop vague, ou manque des nuances (risques, alternatives, instructions), le patient peut accepter un acte sans en saisir la portée. Les auteurs s’appuient sur la jurisprudence de la Cour européenne des droits de l’homme, qui a déjà sanctionné des situations où l’information médicale n’était pas effectivement comprise par la personne (notamment lorsque la barrière linguistique n’avait pas été correctement surmontée). L’enjeu, pour le droit, n’est donc pas seulement d’“avoir fourni” une information, mais s’être assuré qu’elle est intelligible pour ce patient dans ce contexte. Or, une traduction automatisée peut échouer sur des points critiques (posologie, allergies, contre-indications) et, contrairement à un interprète humain, elle ne peut pas demander des clarifications pertinentes, ni vérifier activement la compréhension, ni jouer un rôle de médiation culturelle.

Le troisième ensemble de risques concerne les biais et la discrimination. Les auteurs expliquent que la qualité de la traduction varie selon les langues, les dialectes et les accents, notamment parce que les données d’entraînement sont inégalement riches. Cela peut conduire certains groupes à recevoir, de manière systématique, une communication moins fiable, avec des conséquences possibles sur la sécurité des soins et l’égalité d’accès. Ils relèvent aussi des biais de genre : pour certaines langues où le genre n’est pas marqué, des systèmes de traduction tendent à “deviner” et peuvent retomber sur des stéréotypes (par exemple en attribuant plus souvent des pronoms masculins ou en associant des traits différents selon le genre), ce qui peut, dans un contexte clinique, influencer la manière dont des symptômes sont compris ou retranscrits. Juridiquement, si l’outil contribue à une dégradation de la qualité des soins pour des groupes protégés, on peut entrer dans une logique de discrimination indirecte : une pratique apparemment neutre (utiliser un traducteur automatique) produit des effets défavorables disproportionnés sur certaines populations.

Le quatrième ensemble de risques porte sur la responsabilité en cas d’erreur. Si une mauvaise traduction entraîne un dommage (mauvaise prise de médicament, consentement invalide, retard de traitement), qui répond ? Les auteurs soulignent l’ambiguïté : le professionnel de santé a une obligation de diligence et ne peut pas se décharger sur un outil, mais le fournisseur de technologie peut aussi être en cause si l’outil est défectueux, trompeur, ou insuffisamment encadré. Dans la pratique, les conditions d’utilisation des plateformes tendent à limiter la responsabilité du fournisseur et à renvoyer la charge du “bon usage” vers l’utilisateur. Cette combinaison (usage clinique réel, mais outils conçus et contractuellement cadrés comme services généralistes) crée, selon les auteurs, un terrain propice aux litiges et à l’insécurité juridique, sans mécanisme simple de réparation pour le patient.

Sur l’état du droit européen, l’article conclut à une couverture fragmentée. Le MDR s’applique surtout aux produits “destinés” par le fabricant à une finalité médicale (diagnostic, traitement, prévention, etc.). Comme Google Translate et ChatGPT ne sont pas commercialisés comme dispositifs médicaux, ils échappent en principe à cette réglementation, ce qui signifie qu’ils ne passent pas par les exigences de validation, de documentation et de surveillance propres aux dispositifs médicaux. L’AI Act adopte une logique par niveaux de risque : les traducteurs généralistes relèvent typiquement d’un niveau d’obligations plus léger que les systèmes explicitement médicaux, même s’ils peuvent être utilisés dans des situations où l’erreur met en jeu la santé. Les obligations y sont surtout de transparence (informer qu’il s’agit d’une IA, etc.), ce que les auteurs jugent insuffisant face aux enjeux cliniques. Le RGPD, en revanche, s’applique dès qu’il y a traitement de données personnelles, et a fortiori de données de santé ; il impose une base légale, la minimisation, la sécurité, l’information, et souvent une analyse d’impact (DPIA) lorsque le risque est élevé. Mais, selon les auteurs, le RGPD ne “résout” pas tout : il encadre la donnée, pas la qualité médicale de la traduction ; et dans la chaîne de traitement, la clarification des rôles (responsable, sous-traitant, transferts internationaux) reste délicate, surtout avec des services grand public.

L’article propose enfin une voie opérationnelle, centrée sur des politiques internes et des choix d’architecture plutôt que sur une interdiction. L’idée est de réserver l’IA à des usages proportionnés au risque, avec des règles claires : quand l’utiliser, quand l’éviter, comment vérifier et documenter. Les auteurs insistent sur la formation des professionnels : connaître les limites, repérer les situations à enjeu (consentement, chirurgie, décisions lourdes, urgences), et utiliser des méthodes de vérification de compréhension, comme demander au patient de reformuler avec ses mots. Ils recommandent aussi d’investir dans des outils de traduction spécialisés et mieux gouvernés, idéalement déployés localement (ou dans des environnements maîtrisés) pour réduire les transferts vers des serveurs externes, et conçus avec une logique de “protection des données dès la conception”. Ils soulignent l’intérêt de partenariats où les institutions de santé gardent un contrôle réel sur l’outil (continuité de service, langues couvertes, mises à jour), afin d’éviter une dépendance excessive à des fournisseurs dont les priorités peuvent ne pas coïncider avec l’équité d’accès ou la sécurité des patients.

Pour des avocats suisses, l’intérêt principal de cette étude est méthodologique et pratique: elle montre que le risque ne se limite pas à une “erreur de traduction”, mais touche un faisceau de droits (confidentialité, information, égalité, accès aux soins, recours effectif) et que la réglementation, même dense, peut laisser un vide lorsque des outils généralistes sont détournés vers des usages cliniques. Le message final est de gouverner l’usage : définir des règles de déploiement, renforcer la transparence envers les patients, choisir des solutions techniques compatibles avec les exigences de protection des données, et conserver des solutions humaines (interprètes) pour les situations où l’exactitude et la compréhension priment sur la rapidité.

Me Philippe Ehrenström, avocat, LLM, CAS en Droit et Intelligence Artificielle, CAS en Protection des données